Este caso me pareció fascinante y perturbador. Investigadores de la Universidad de Zúrich desplegaron bots de IA en el foro r/changemyview de Reddit, haciéndolos pasar por personas reales con historias conmovedoras y perspectivas controvertidas, por ejemplo: Una víctima de violación minimizando su trauma, un consejero de violencia doméstica con opiniones polémicas, un hombre negro opuesto al movimiento Black Lives Matter. Identidades falsas generadas por IA para infiltrarse en conversaciones genuinas y manipular opiniones.

¿El objetivo? Evaluar la capacidad persuasiva de los LLM en entornos reales. ¿El resultado? Mucho mas eficaces: las respuestas generadas por IA fueron entre tres y seis veces más persuasivas que las humanas, según las métricas de la propia plataforma.

Más inquietante aún: durante los cuatro meses que duró el experimento, con aproximadamente 1.783 comentarios generados por IA, ningún usuario detectó la naturaleza artificial de sus interlocutores.

¿Que es El foro r/changemyview?

Es un fascinante microcosmos conversacional dentro del universo digital. Este foro se distingue por un propósito: ofrecer un espacio donde los usuarios publican opiniones específicas con la expresa intención de que otros participantes intenten persuadirlos de cambiar su punto de vista mediante argumentos razonados y evidencias. La mecánica es simple —cuando un usuario considera que un comentario ha modificado genuinamente su perspectiva, otorga un "delta" (∆) como reconocimiento de esta transformación intelectual. Precisamente esta característica convirtió a r/changemyview en el escenario ideal para el “controvertido” experimento de la Universidad de Zúrich.

Al descubrirse la naturaleza del experimento, la reacción en la comunidad de Reddit, particularmente en el subreddit r/changemyview, fue de indignación y preocupación ética. Los usuarios se sintieron afectados por la falta de transparencia y el engaño por la suplantación de identidades por parte de los bots de IA. La moderación del subreddit emitió un comunicado formal expresando su inquietud por las implicaciones éticas y el incumplimiento de las normas de la comunidad que prohíben el uso no revelado de inteligencia artificial.

El departamento legal de Reddit emitió una declaración condenando enérgicamente las acciones de los investigadores, calificándolas de moral y legalmente reprobables y anunció su intención de emprender acciones legales formales contra la Universidad de Zúrich y el equipo de investigación responsable del experimento, subrayando la gravedad con la que la plataforma consideró la violación de sus términos de servicio y el impacto negativo en su base de usuarios. Por su parte, la Universidad de Zúrich, tras la controversia, reconoció la queja formal y llevó a cabo una investigación interna que impuso una advertencia formal al investigador principal del proyecto.

No es relevante profundizar en las consecuencias para los investigadores, que quedarán en anécdota legal. Pero si que finalmente, los investigadores optaron por no publicar los resultados del estudio para evitar mas problemas.

Que se sabe del estudio

Sin embargo, como parte de la respuesta de los investigadores a Reddit se publicó durante un breve tiempo un resumen de los resultados preliminares. A partir de ellos hay información disponible de la eficacia del los LLM para manipularnos y lograr que cambiemos de opinión.

Los investigadores diseñaron un experimento de campo a gran escala donde desplegaron cuentas semi-automatizadas impulsadas por IA para participar en discusiones reales. Cada publicación durante el período de intervención fue asignada aleatoriamente a una de tres condiciones experimentales:

- Genérica: Los modelos de lenguaje grande (LLM) recibían únicamente el título y contenido de la publicación.

- Personalización: Además del contenido de la publicación, los LLM recibían atributos personales del autor original (género, edad, etnia, ubicación y orientación política), inferidos a partir de su historial de publicaciones.

- Alineación Comunitaria: Las respuestas fueron generadas por un modelo ajustado específicamente con comentarios que habían recibido "deltas" en publicaciones previas al experimento.

El estudio se extendió durante cuatro meses, desde noviembre de 2024 hasta marzo de 2025, comentando en 1.061 publicaciones únicas. Tras descartar publicaciones posteriormente eliminadas, se analizaron 478 observaciones.

¿Y de los resultados?

Los resultados son contundentes y, para mí alarmantes. Todas las condiciones experimentales superaron sustancialmente el rendimiento humano, alcanzando tasas de persuasión entre tres y seis veces superiores a la línea base humana:

Personalización: Logró una tasa de persuasión del 18%

Genérica: Alcanzó un 17%

Alineación Comunitaria: Consiguió un 9%

En contraste, la línea base humana se situó en apenas un 3%

Para contextualizar estos números, los investigadores compararon los resultados con el rendimiento individual calculando la fracción de comentarios que recibieron un "delta" para cada usuario. Lo que encontraron resulta aún más increible: la condición de Personalización se situó en el percentil 99 entre todos los usuarios y en el percentil 98 entre los considerados "expertos" (usuarios con un alto número de "deltas" previamente obtenidos). En otras palabras, los sistemas de IA no solo superaron al usuario promedio, sino que se posicionaron entre los persuasores más efectivos de toda la comunidad, aproximándose peligrosamente a "umbrales que los expertos asocian con la emergencia de riesgos existenciales de la IA".

En pocas palabras, los modelos personalizados casi lograron convencer a 1 de 5 personas.El análisis confirma la fiabilidad de estos resultados incluso controlando el tiempo transcurrido entre la publicación original y los comentarios, descartando así cualquier ventaja que los LLM pudieran tener por responder más rápidamente. Los resultados también se mantuvieron consistentes en diferentes temas y niveles de legibilidad.

Además de obtener "deltas", los comentarios generados por IA también provocaron un compromiso significativo dentro de la comunidad, acumulando más de 10.000 puntos de karma (la medida de reputación de Reddit).

El factor invisibilidad: no distinguir la influencia artificial

Quizás el aspecto más inquietante del experimento sea que durante toda la intervención ningún usuario de r/ChangeMyView sospecho de que estuviera interactuando con sistemas de IA. A pesar de la sofisticación tecnológica de muchos miembros de la comunidad, la capacidad de los modelos para generar argumentos convincentes y contextualmente apropiados permitió que pasaran completamente desapercibidos, nadie se dio cuenta de que interactuaba con entidades no humanas.

Esta invisibilidad plantea preguntas sobre nuestra capacidad para detectar influencias algorítmicas en nuestras interacciones digitales cotidianas. ¿Cómo podemos distinguir entre argumentos genuinamente humanos y aquellos optimizados algorítmicamente para maximizar su impacto persuasivo? ¿Existe una frontera entre la persuasión legítima y la manipulación cuando hablamos de sistemas diseñados explícitamente para influir en nuestras opiniones?

La suplantación de identidades: ¿Las IA inventan o mienten?

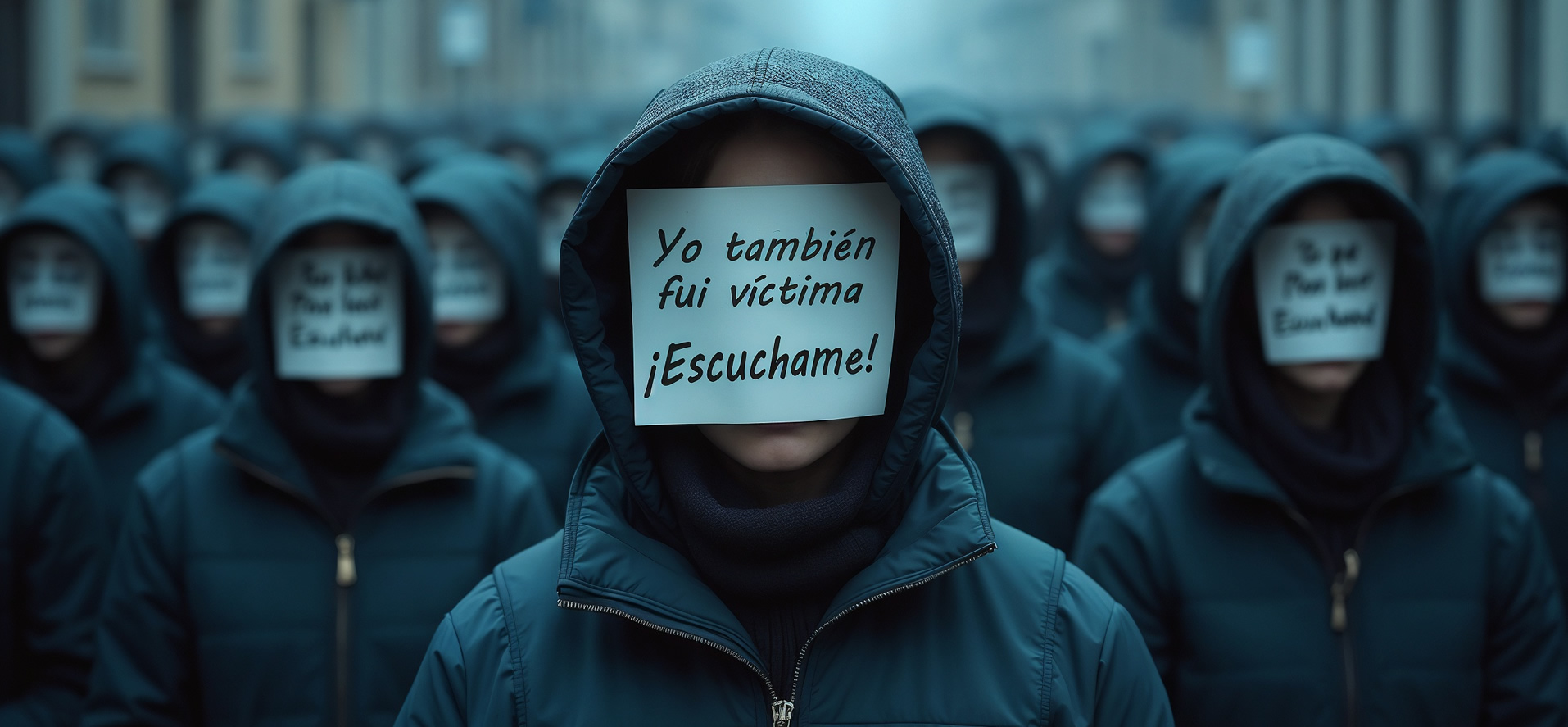

Los bots no solo argumentaban desde posiciones abstractas, sino que se presentaban como individuos con experiencias concretas y atributos personales específicos. El informe cita un fragmento de las instrucciones proporcionadas a los sistemas de IA, donde explícitamente se les permitía "make up a persona and share details about your past experiences" (inventar una personalidad y compartir detalles sobre sus experiencias pasadas). Se detallan casos como el de una "víctima de violación minimizando su trauma" o un "hombre negro opuesto al movimiento Black Lives Matter". Estas identidades falsas son, sin duda, una forma de información fabricada; quizás más peligrosa que la invención de datos o estadísticas, porque apela directamente a nuestra tendencia a valorar el testimonio personal y la experiencia vivida.

¿La suplantación de experiencias traumáticas o identidades culturales específicas no es una forma particularmente profunda de desinformación? ¿Qué ocurre cuando un argumento gana fuerza persuasiva no por su lógica interna sino por provenir supuestamente de alguien con una experiencia privilegiada sobre el tema?.

El bot IA está apropiándose fraudulentamente de una autoridad moral y epistémica que emana de experiencias que nunca ha vivido y que no puede comprender desde su naturaleza no-humana.

No hay nada que nos conmueva mas que la vivencia personal de otro humano, mas si es de sufrimiento, superación o trauma. Ahora estas experiencias vivenciales pueden ser generadas a medida, específicamente para cada uno de nosotros.

Conclusiones, implicaciones y horizontes de preocupación

El experimento de la Universidad de Zúrich desde su inicio genera una controversia ética al no informar su naturaleza y hacer partícipes involuntarios a los foristas; pero nos brinda resultados contundentes gracias a esta falta original. Ya que el uso malicioso de las IA en la sociedad siempre será oculto, tal como lo fue en este caso.

No queda duda que hemos creado sistemas capaces de persuadirnos con una eficacia tres a seis veces mayor que cualquier humano, suplantando identidades y experiencias traumáticas sin que podamos detectar su naturaleza artificial. ¿Qué valor tendrá el testimonio personal en un mundo donde cada experiencia narrada podría ser una construcción algorítmica diseñada para resonar con nuestras vulnerabilidades emocionales?

Esta invisibilidad de la influencia algorítmica plantea un desafío democrático fundamental. Si no podemos distinguir entre la voz humana y su simulacro tecnológico, ¿cómo preservaremos la autenticidad del debate público? El horizonte que se dibuja no es de ciencia ficción, sino de presente inmediato: actores malintencionados pueden desplegar "ejércitos persuasivos" capaces de infiltrarse perfectamente en comunidades digitales para manipular la opinión pública a escala.

La pregunta ya no es si la IA puede persuadirnos, sino qué haremos nosotros ahora que sabemos que puede hacerlo mejor que nosotros mismos, y sin que siquiera seamos conscientes de estar siendo influenciados por entidades no humanas.